Artificiell intelligens (AI) utvecklas snabbt och kräver stora beräkningsresurser för att fungera effektivt. Grafikkort, eller GPU:er, har blivit en central del i denna utveckling. Till skillnad från vanliga processorer är GPU:er designade för att hantera många parallella beräkningar samtidigt – vilket gör dem särskilt väl lämpade för AI-uppgifter som maskininlärning och neurala nätverk. I den här artikeln förklarar vi hur AI fungerar i GPU:er, varför deras arkitektur passar så bra för dessa komplexa beräkningar och hur de driver innovation inom allt från bildigenkänning till självkörande bilar.

Varför GPU:er är idealiska för AI-beräkningar

GPU:er, eller grafikkort, utvecklades ursprungligen för att hantera grafik och bilder i datorer och spel. Men deras arkitektur har visat sig vara extremt effektiv för att utföra de komplexa matematiska beräkningar som krävs inom artificiell intelligens (AI). Den främsta anledningen är att GPU:er kan arbeta med tusentals parallella beräkningar samtidigt, något som traditionella CPU:er inte klarar i samma omfattning.

Parallell bearbetning – hjärtat i GPU:er

En CPU består vanligtvis av några få kraftfulla kärnor som arbetar sekventiellt, vilket är optimalt för generella uppgifter. En GPU däremot har hundratals eller till och med tusentals mindre kärnor, specialiserade på att utföra samma operation på många dataelement parallellt. Denna design gör GPU:er särskilt bra på uppgifter där stora datamängder ska behandlas samtidigt, vilket är fallet i AI-algoritmer som tränar neurala nätverk.

AI och massiva matrismultiplikationer

Många AI-algoritmer, framförallt inom maskininlärning, bygger på matris- och vektorberäkningar. Träning och inferens i neurala nätverk innebär att man multiplicerar och adderar stora matriser med data och viktningar. GPU:ernas parallella arkitektur är skräddarsydd för just sådana operationer, vilket gör att de kan utföra dessa beräkningar mycket snabbare än vanliga processorer.

Effektivare energianvändning för AI-uppgifter

Utöver hastigheten är GPU:er ofta mer energieffektiva när det gäller att utföra AI-relaterade beräkningar. Det beror på att parallell bearbetning tillåter att många beräkningar görs samtidigt utan att klockfrekvensen behöver vara extremt hög. Detta innebär att AI-system kan skala upp sin beräkningskraft utan att energiförbrukningen ökar oproportionerligt.

Optimerade bibliotek och hårdvarufunktioner

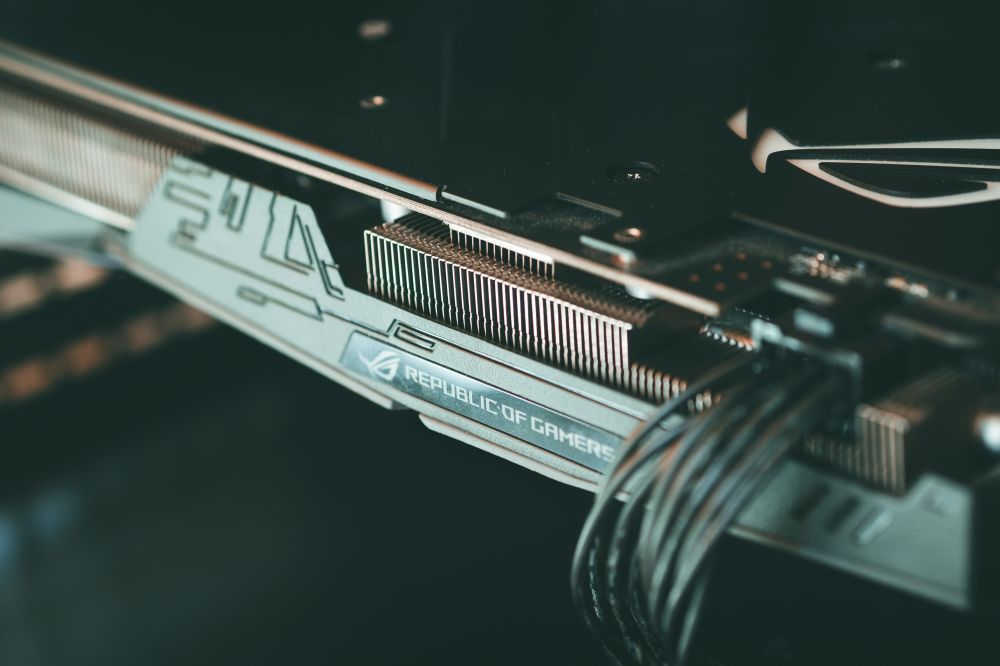

För att maximera prestandan inom AI har många GPU-tillverkare utvecklat specialiserade mjukvarubibliotek och hårdvarufunktioner. Till exempel erbjuder NVIDIA sina CUDA-bibliotek som förenklar programmeringen av AI-uppgifter på GPU:er. Dessutom finns dedikerade AI-acceleratorer i modernare GPU:er som Tensor Cores, som är speciellt utformade för att snabba upp maskininlärningsberäkningar.

Maskininlärning och neurala nätverk på GPU:er

Maskininlärning och neurala nätverk är centrala delar inom artificiell intelligens, och deras effektivitet beror ofta på hur snabbt och kraftfullt de kan tränas och köras. Här spelar GPU:er en avgörande roll. Tack vare deras parallella beräkningsförmåga kan GPU:er hantera den stora mängd data och de komplexa matematiska operationer som krävs för att utveckla och använda dessa AI-modeller.

Träning av neurala nätverk

Att träna ett neuralt nätverk innebär att modellen anpassar sina interna parametrar, eller vikter, för att känna igen mönster i data. Den processen kräver upprepade beräkningar av matrismultiplikationer och gradientnedstigning, där varje lager i nätverket justeras steg för steg. GPU:er kan utföra dessa uppgifter mycket snabbare än traditionella processorer, eftersom de kan bearbeta tusentals beräkningar parallellt. Det innebär att komplexa modeller kan tränas på betydligt kortare tid, vilket är avgörande för att snabbt ta fram och förbättra AI-lösningar.

Inferens – att använda den tränade modellen

När ett neuralt nätverk väl är tränat används det för inferens, alltså att göra förutsägelser eller beslut baserade på ny data. Även här är GPU:ers parallella arkitektur viktig eftersom inferens ofta innebär att modellen snabbt ska analysera stora mängder data. GPU:er möjliggör realtidsbearbetning i applikationer som röstigenkänning, bildanalys eller självkörande bilar.

Optimering av AI-arbetet på GPU:er

För att utnyttja GPU:ernas fulla potential i maskininlärning finns specialiserade ramverk och bibliotek, som TensorFlow och PyTorch. Dessa verktyg är designade för att effektivt fördela beräkningar till GPU:erna och hantera stora datamängder smidigt. De erbjuder också möjligheter att använda avancerade hårdvarufunktioner, som NVIDIA:s Tensor Cores, som ytterligare snabbar upp AI-beräkningar.

Skalbarhet och flexibilitet

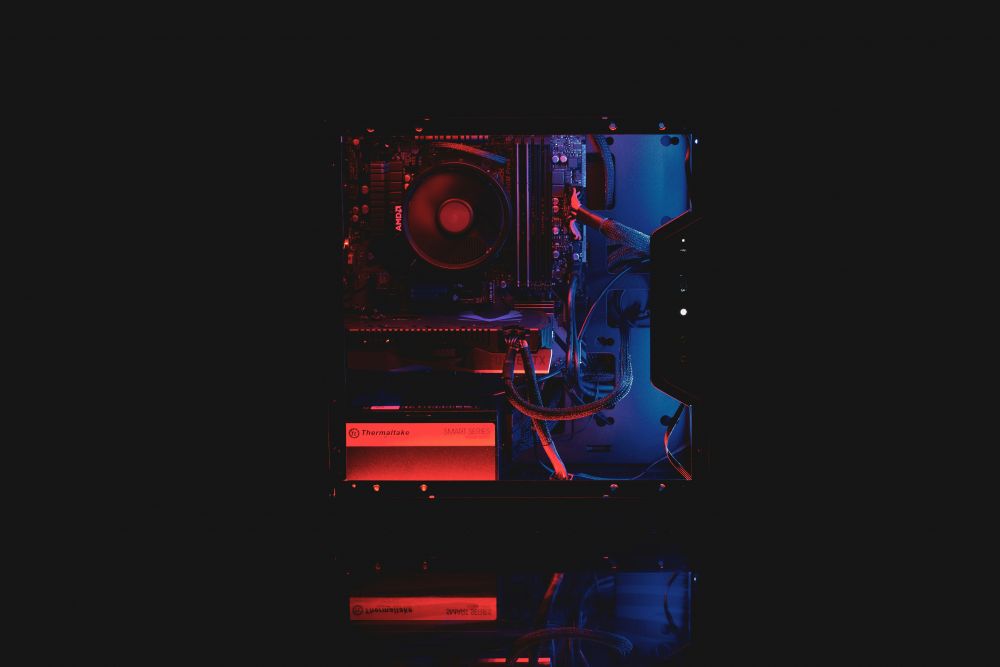

En annan fördel med GPU:er i AI-utveckling är deras skalbarhet. Flera GPU:er kan kopplas ihop för att träna större och mer komplexa modeller än vad en enskild enhet klarar. Denna flexibilitet är avgörande för forskare och företag som arbetar med storskaliga AI-projekt och vill kunna anpassa beräkningskraften efter behov.

Framtidens AI-utveckling med kraftfulla GPU:er

GPU:ernas roll i artificiell intelligens fortsätter att växa i takt med att AI-teknologin utvecklas. Nya generationer av grafikkort erbjuder inte bara högre prestanda utan också specialiserade funktioner som gör det möjligt att ta AI till nästa nivå. Den här utvecklingen öppnar dörrar för mer avancerade och effektiva AI-lösningar inom många olika områden.

Mer än bara rå beräkningskraft

Framtidens GPU:er fokuserar inte enbart på att bli snabbare, utan också på att bli smartare. De innehåller nu dedikerade AI-acceleratorer, som Tensor Cores och RT Cores, som är särskilt anpassade för att hantera maskininlärningsuppgifter och realtidsrendering. Dessa specialfunktioner gör att AI-modeller kan tränas och köras ännu snabbare, samtidigt som energiförbrukningen hålls nere.

Utveckling av nya AI-arkitekturer

Med kraftfullare GPU:er kan forskare och utvecklare experimentera med mer komplexa och djupa neurala nätverk. Det gör att AI kan lära sig från större datamängder och lösa svårare problem, som naturlig språkbehandling, bildigenkänning och självkörande teknik. GPU:ernas flexibilitet gör det möjligt att anpassa och optimera dessa modeller för olika ändamål, från medicinsk diagnostik till automatiserad produktion.

Skalbarhet för stora AI-projekt

En viktig aspekt i framtidens AI är möjligheten att skala beräkningsresurser. Moderna AI-system använder ofta flera GPU:er i parallell, både inom en och samma server och i stora datacenter. Den här skalbarheten innebär att även mycket stora och komplexa AI-modeller kan tränas på rimlig tid, vilket gör avancerad AI tillgänglig för fler företag och organisationer.

Hållbarhet och energieffektivitet

Med ökande beräkningsbehov blir energieffektivitet allt viktigare. Nya GPU-arkitekturer designas med fokus på att ge hög prestanda samtidigt som energiförbrukningen minimeras. Det gör att AI-tillämpningar kan växa utan att påverka miljön i onödan, vilket är avgörande för hållbar teknikutveckling.

Vad innebär detta för framtiden?

Med kraftfulla GPU:er som driver AI framåt kan vi förvänta oss snabbare innovationer och fler praktiska tillämpningar. AI kommer att bli mer tillgängligt, mer precist och kunna hantera alltmer komplexa uppgifter. För företag och utvecklare innebär det nya möjligheter att skapa smarta lösningar som förbättrar både produktivitet och livskvalitet.